【全文】

(一)法律原则的适用--基于人工智能技术带来的机遇

(二)法律价值的衡量--基于人工智能技术带来的风险

三、人工智能技术发展法律规制之必要性--以风险产生为切入点

(一)法律风险--制度空白与职责不明产生的监管缺位效应

(二)异化风险--算法升级与信息洪流产生的风险积聚效应

(三)隐私风险--商业逐利与全能政府产生的算法黑箱效应

四、人工智能技术发展法律规制之路径新探--以风险应对为切入点

一、人工智能技术的历史回顾与现代展望

据历史典籍《列子·汤问》[1]记载,公元前10世纪的西周,穆王西巡狩猎偶遇偃师,见偃师手中玩偶似真人一般,“趣步俯仰,信人也。巧夫!”穆王非常吃惊,于是让嫔妃们一同观看。表演结束之时,玩偶朝着穆王的嫔妃们眨眼挑逗,穆王很生气,下令要杀偃师,偃师急忙将玩偶拆开,便看见玩偶是由皮革、木头以及颜料组成的,虽都是假的物件,但是五脏六腑全都具备。“皆傅会革、木、胶、青之所为。内则肝胆、肠胃,外则筋骨、齿发,皆假物也,而无不毕具者。”穆王此时惊叹道,人的技艺竟然能和天地自然有一样的效果,“人之巧乃可与造化者同功乎?”[2]这一历史记载便可以看出,在遥远的古代,我国祖先便对“类人化”的技术进行追逐与探索。随着时代的推移与科技的发展,新时代的“偃师”们再一次将“类人化”的技术——人工智能技术发展至新高度,以回应祖先对人工智能机器人的原始憧憬与可贵探索。

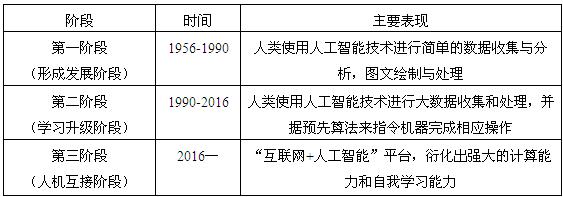

纵观人工智能技术的发展历程,其在1956年的达特茅斯会议上[3]被首次定义。但囿于时代所具有的局限性,知识获取遇到瓶颈,算法升级、计算能力以及数据分析难以更进一步,人工智能的发展受到一定影响。但随着上述问题的解决,人工智能技术的研究、开发和应用又开启了新的阶段。新时期,从“互联网+”时代到“人工智能+”时代,新经济在急遽发展,人工智能技术方兴未艾,其发展再次进入一个崭新的阶段。总结其发展历程,大致可分为三个阶段:1.第一阶段:主要为形成发展阶段(1956年-1990年)[4];2.第二阶段:主要为学习阶段(1990年-2016年)[5];3.第三阶段:主要为人机互接阶段(2016年至今)。[6](表1)如今人工智能技术的发展正处于第三阶段,其不仅已经成为第二次、第三次工业革命之后的新经济引擎,而且成为时下国际竞争的新焦点。[7]一个给人类带来越来越多便利,日益影响人类生产、生活的“人工智能时代”正悄然向我们走来。[8]当然我们知道,人工智能技术的发展,带来机遇有目共睹,产生风险也是在所难免,应勇立潮头,抓住机遇;从容应对,规避风险。尤其是面对如何规避风险,完善顶层设计,加强监管规制,是我们法律人亟须解决的重要课题。

(资料来源:据黄欣荣、王禄生、周志华及於兴中等教授论文及其他相关数据资料整理)

人工智能技术给人类所带来的益处是明显的。首先,它通过完成高强度的重复性劳动从而极大提高劳动效率并解放劳动力,如:进行机械化的流水线作业、简单化的组合拼装等;其次,在一些对安全性、准确性和稳定性要求较高的领域,极大地排除了人类由于自身情感以及人性等方面的固有缺陷[9]所带来的负面影响。[10]如:医疗领域(医疗器械)、交通领域(自动驾驶)以及司法领域(司法大数据)等;最后,由于人工智能技术“类人化”的特征,其在一定程度上对人类也起到了精神上的陪伴与慰藉作用。如:智能机器人陪伴空巢老人;智能护士陪伴卧床病人等。可见人工智能技术已经带来了经济、社会以及法律等诸多领域的深刻变革。[11]然而,由于技术的中立性,其向来都是好坏参半的,人工智能技术既赋予我们颠覆性的创造,也给我们带来了颠覆性的毁灭。[12]如:人工智能技术对人类生命安全造成的威胁[13]、对信息安全乃至国家安全带来的挑战[14]以及对法律社会伦理形成的冲击等。然而我们并不能等到实践中涌现大量的问题之后才进行相应的制度建设予以规制,那样为时已晚,所以应未雨绸缪,在人工智能技术可能带来的问题来临之前进行前瞻性的法律与制度设计。[15]此外,不仅法学界对该问题异常关注,甚至连科技界也提出相似论断:“我们的法律体系亟须积极主动学习并使用专业知识和必要手段来预测我们人工智能技术的未来,讨论安全、责任、平等和生活质量这些重要问题,为21世纪创设一套较为可行的法律制度框架,而非当发现新法律问题之后被动地进行一一回应。”[16]所以在出台一系列法律与政策促进人工智能产业发展并充分发挥其积极作用的同时,如何对人工智能技术产生的负面影响进行有效规制,皆是摆在法律面前的一道时代命题,也是不断促进法学理论发展的时代载体。

二、人工智能技术发展法律规制之必要性——以风险产生为切入点

正如前文所述,在人工智能发展的过程中,法律以不同的形式进行回应。面对人工智能技术给人类带来的机遇,予以鼓励和促进;面对人工智能技术给人类带来的风险,予以规制甚至消除。无论是积极鼓励还是消极规制,法律的作用皆为给人工智能技术的发展创造良好的市场环境与制度基础。由于近些年,国家对人工智能技术发展予以大量的政策扶持,[17]且效果明显。然对其在发展过程中可能产生的风险并无健全的规制机制,此时对风险的防控显得尤为必要。笔者将从人工智能技术发展过程中可能产生的风险入手,分析对其进行法律规制的必要性。

(一)法律风险——制度空白与职责不明产生的监管缺位效应

即便我国为促进人工智能技术发展而出台了大量的政策计划,但不可否认,我国对人工智能技术发展过程中所产生的消极影响的规制并没有完善的措施与健全的制度。我们应清醒地认识到,人工智能技术发展日新月异,其在发展的过程中存在着大量的不确定性[18],同时又伴随着其在研发设计、信息搜集以及成果应用环节存在大量的制度空白以及监管缺位,这些大量的法律空白倘若被不法分子利用,将产生无法设想的后果。

同时,我国对人工智能技术的监管并不到位,不论是在初期的技术研发阶段,还是在中期的算法策略阶段,亦或是在后期成果应用阶段,政策扶持的力度很大,但对其制度监管方面显得相对不足,没有较为明确的职能部门负责。由于技术的中立性,和所有技术一样,人工智能技术也可能会落入不法之徒手中,[19]如今利用新兴人工智能技术进行犯罪的案件越来越多,加之该技术具有高科技性、复杂性、隐蔽性等特征,对其打击难度和成本也越来越大,长此以往,从而使其成为违法犯罪的重要手段。[20]在此情况下,监管部门职责不明所产生的监管空缺将成为这些犯罪分子规避法律制裁的完美救生衣。

(二)异化风险——算法升级与信息洪流产生的风险积聚效应

由于人工智能技术进入了快速发展的阶段,人工智能“类人化”的特征越来越明显,比如:人工智能技术发达的信息收集能力、信息分析能力以及自我学习能力都得到了突飞猛进的进步。虽然人工智能是在人类预设的算法下进行运算的,但由于人类自身认知水平和认知能力的局限性,其计算能力和知识调用能力和每秒运算“百亿亿”级的计算机相比,[21]还是有很大不足。在此情况下,人工智能在信息分析和自我学习时很可能会在已有算法的基础之上,进行算法的不当升级,从而产生自我异化的风险。如:通过修改自我运算程序可能产生危害人身安全与财产安全的风险;通过泄露机密信息可能产生危害商业安全乃至国家安全的风险等。更为严重的是,一旦人工智能进一步异化发展,其可能产生更加难以设想的恐怖后果,这种说法看似杞人忧天,但在算法不断升级的今天,如果无法有效管控算法技术产生的“信息洪流”,[22]其产生“互联网技术不仅没有被人类控制,反而变成了掌控者”这一结果也并非完全没有可能,[23]从2015年7月英国《金融时报》报道的德国大众公司机器人“杀人事件”便可窥见一斑。[24]在这种情况下,算法统治世界,这不仅会对人类自身安全产生危害,同时也会引发人类对自身身份认知的危机,[25]这都是我们人类不想看到的结果。

需要进一步考虑的是,异化风险会产生相应的损害结果,不管是对人身安全的伤害,还是对国家安全、商业安全的侵害,都会涉及到相应的责任划分和损害赔偿问题。这时,需要分清在何环节产生了异化风险:是在人工智能技术设计研发环节中就被研发者加入恶意程序;还是在制造环节被制造组装者植入不法芯片篡改算法;亦或是在成果应用环节中被不法分子恶意利用,于不同的环节出现问题,其责任划分和损害赔偿最终的结果也不尽相同。同时,还须解决一个重要的问题——人工智能的主体性质,是将“它”作为传统意义上归人类支配占有的物,还是赋予“他/她”独立法律人格并使其自负其责,不同的认定都将产生不同的责任认定标准。

(三)隐私风险——商业逐利与全能政府产生的算法黑箱效应

人工智能技术发展所带来的另一个风险:算法黑箱[26]社会现象加剧。其导致用户对自身信息流向何处并不知晓,只能被动接受设计者们设计算法所产生的最终结果,但有些会对我们产生重要影响的信息只有“局内人”(设计者们)才能获得,[27]往往掌握算法的“局内人”都是具有逐利性质的企业,此时对于过度商业资本追求以及价值偏好等都会成为“局内人”凭借算法侵蚀用户利益的重要因素,此时我们的一切个人隐私将完全暴露在具有商业逐利性的企业面前。在此情况下,会形成更加严重的信息壁垒与数字鸿沟。[28]在人工智能和大数据急遽发展的今天,这一信息壁垒和数字鸿沟主要反映在“大数据杀熟”这一领域,大数据是人工智能的基础,人工智能进行学习主要来源于互联网提供的海量信息。然而虽然所有的个人数据[29]都由我们自身产生,但所有权并不归属于我们。[30]这样的做法很明显侵害我们的个人信息权。[31]我们对个人信息应当具有所有权并可决定其是否被利用以及以何种方式被利用,同时也有权要求消除因其被不当利用所产生的消极影响。另外,当下社会财富的积累不再仅仅靠出卖劳动力和简单投资来获取,更多的是通过占有信息、分析数据以及算法建模等方式来迅速成为商业巨头,[32]甚至可以说是成为商业寡头。从阿里巴巴、腾讯等商业巨头的成长史来看,这些企业都拥有着大量的个人信息,并通过相应的算法程序,使这些个人信息成为他们更好盈利的资源和手段。同时,根据对这些个人信息进一步的分析、建模,形成更加精准的算法,从而使得盈利呈指数倍增加。在这种情况下,就会在商业巨头与普通民众之间形成更加严重的信息壁垒和数字鸿沟。

此种情况下,拥有“全能政府”[33]的国家便会出台相关法律和政策进行规制,此时国家介入便显得理由充分。但是,由此便会带来另外一个问题,政府规制算法的能力便会增强,个人的信息数据由完全暴露在企业面前转化为完全暴露在政府面前,此时我们便仿佛置身于一个全是探头的社会,无疑变成了裸奔的“玻璃人”。[34]一切信息都将掌握在政府手中,此时,我们有理由怀疑,人工智能所带来的,是更加完善的民主,还是更具有潜伏性的专治?[35]此时,平衡好“局内人”与“政府”之间的关系,预防因商业逐利与全能政府所产生的算法黑箱风险,便是我们必须直面的命题。

三、人工智能技术发展法律规制之路径新探——以风险应对为切入点

1.完善顶层设计,填补法律漏洞。法律在设计的过程中,应综合把握人工智能技术发展的不同阶段。首先针对研发设计阶段,应加强对人工智能机器人研发设计标准的规范,进行严格的事前审查,防止被加入恶意程序;[36]其次针对算法运用过程,对算法进行实时监控,同时为弥补法律固有的滞后性特征,此时可加强过程规制与监管,即利用代码去规制代码,秉持“技术法律化”“算法法律性”的创新立法理念;[37]最后针对成果应用阶段,尤其需要对网络犯罪、黑客以及非法链接等进行风险防控和必要的打击,[38]加大法律惩戒力度。这样,在事前、事中和事后环节都进行相应的制度设计,对人工智能技术在不同环节可能产生的风险加强防范与规制,最终实现良法善治。

2.明晰职责分配,实现精准监管。面对职能部门自身职责不明这一现状,应厘清人工智能技术发展中所产生风险的不同阶段,合理划分职责分配。[39]首先在前期阶段,主要是技术的研发设计阶段,科技部门作为人工智能技术的主管部门,应建立相关市场准入机制,加强对人工智能技术的合法性、伦理性排查,在进行道德风险评估之后方能允许该技术进行研发;其次在中期数据采集与算法运用阶段,工信部门对数据的采集和算法的应用调试应加强过程监管[40],实时监控数据、算法流量,对发现的侵害公民个人信息的情况及时进行查处,降低数据滥用的风险;最后在成果应用阶段,质监部门应当对最终的产品质量进行检测,要求企业对投入实际应用中不合格的产品进行召回。不过需要我们注意的是,由于人工智能技术是新兴技术,其对促进经济发展和社会进步都具有重大意义,明晰主管部门职能,实现精准监管的一切出发点都是为其健康发展创设更好良好的外部环境,如今政府也强调简政放权,监管过度恐过犹不及。为防止出现“全能政府”[41]以及“审批经济”[42]等干预过度的情形发生,在此基础上,国家可在中央层面成立人工智能领导小组,由法律界、科技界、伦理界以及政界的专家组成,避免由于知识和视野、思维方式与考虑角度等方面的局限性导致小组运行低效。[43]负责人工智能技术发展过程中的重大决策、规划以及工作部署,并对各监管部门监管方式的合法性进行监督和抽查,易言之,这是对监管的“再监管”、对审查的“再审查”,[44]对过度干预的监管部门细化追责机制和程序,从而为深化“放管服”改革提供顶层设计保障,为人工智能技术的发展创造良好的市场环境与制度基础。

1.限缩风险范围,降低风险系数。面对异化风险,不仅需要加强各职能部门的规范管理,分阶段地切实防范人工智能技术异化所可能产生的风险,还应当将其异化风险限缩在人类的可控范围之内。简言之,可在人工智能产品的研发设计之初,设计“一键还原”系统,当该技术出现异化风险,并将对人类安全产生重大危害时,使其一键还原,从而减少因人类认知局限性所带来的危害,从源头上规避因算法不断升级所带来的异化风险。

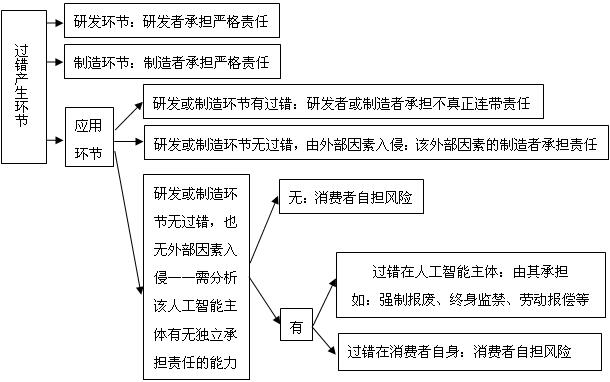

2.合理划分环节,明确责任分配。针对异化风险所产生的责任划分以及损害赔偿问题,笔者认为,仍应根据技术发展的不同环节,进行合理的责任分配。首先,针对技术研发设计环节,应实行研发者承担严格责任;其次,针对制造(算法运用)环节,应实行制造者承担严格责任;最后,针对应用环节:(1)若研发或制造环节有过错,研发者和制造者承担不真正连带责任;(2)若研发或制造环节无过错,仅为外部因素(如:被犯罪分子不法利用;被黑客篡改算法等)侵入,由该外部因素的制造者承担责任;(3)若研发或制造环节无过错,也无外部因素侵入,则还需分析该人工智能主体有无独立承担责任的能力[45]:1若无,则由消费者自己承担相应责任;2若有,仍需分析过错归属于人工智能主体还是消费者:a.过错在人工智能主体,由其自身承担,如强制报废、终生监禁以及劳动偿还等;b.过错在消费者:消费者自己承担相应责任。(表2)

1.建立审核机制,促进算法公开。对于掌握海量个人信息的“局内人”,应建立事前审查和事后监管的规制机制。首先在事前,应建立完善的市场准入制度,将不符合要求的“局内人”清除出市场;其次在事中,促进算法公开、信息公开,将算法简化成大众易了解的形式进行公开,同时民众可以要求侵犯个人隐私的信息进行删除并要求“局内人”禁止利用其个人信息并禁止向其发送广告;[46]最后通过事后监管,将在市场运行中侵害用户权益的“局内人”剔除并施加相应的惩处措施,使其成为真正意义上的“局外人”,对于“局外人”,也应根据其对社会的损害程度设置相应的禁入期。通过对全程进行监管,尤其是通过算法公开的方式,进一步化解人工智能技术所带来的隐私风险。

2.打造谦抑政府,防止政府失灵。对于政府,在如今简政放权,深化“放管服”改革的大背景下,应遵循“谦抑”原则,摒弃“全能政府”的理念。众所周知,市场会失灵,会给经济发展造成重大损害,相应的,政府在一定情况下也会失灵,而政府失灵所造成的危害往往较市场失灵更大。[47]所以政府的规制之道,应提供相对原则性、方向性的指引,而非事无巨细进行干预,此可减少政府部门不必要的事权和事务,降低其开支和汲取意愿。[48]因此,合理划定公权力和私权利之间的边界,秉持“轻重理论”[49]的内涵,对于公权力的介入持审慎态度,公权力也应秉持“谦抑”理念,减少政府权力对新兴领域的过度干预,从而更好地维护政府的公共性和权威性。

人工智能技术的发展是人类实现自身解放的重大机遇,其不断地促进经济发展与社会进步。但我们应当清醒地认识到,机遇与风险总是结伴而行、形影不离的。面对人工智能技术发展过程中给我们带来的挑战与风险,应理性分析,积极应对。以完善顶层设计,实现精准监管为基础;不断明确职能分配,降低风险系数;从而通过促进算法公开,打造谦抑政府,为人工智能技术的发展创设良好的市场环境与制度基础。只有这样,我们才能正确把握人工智能技术给我们带来的机遇,化解其在发展过程中的风险,迎来一个真正由算法定义[50]的人工智能时代。

【注释】

[1] 列子:《列子·汤问》,景中译注,中华书局2007年版,第163-164页。

[2] 穆王惊视之,趣步俯仰,信人也。巧夫!领其颐,则歌合律;捧其手,则舞应节。千变万化,惟意所适。王以为实人也,与盛姬内御并观之。技将终,倡者瞬其目而招王之左右侍妾,王大怒,立欲诛偃师。偃师大慑,立剖散倡者以示王,皆傅会革、木、胶、漆、白、黑、丹、青之所为。内则肝胆、心肺、脾肾、肠胃,外则筋骨、支节、皮毛、齿发,皆假物也,而无不毕具者。穆王始悦而叹曰:“人之巧乃可与造化者同功乎?”

[3] 1956年达特茅斯会议首次定义“人工智能”。人工智能(AI)是以研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的科学技术。中国电子技术标准研究院:《人工智能标准化白皮书(2018版)》,2018年版,第5页;尼克:《人工智能简史》,人民邮电出版社2017年版,第83-90页;吴汉东:《人工智能时代的制度安排和法律规制》,载《法律科学》2017年第5期;陈自富:《前弗雷格时期的思维形式化》,载《上海交通大学学报(哲学社会科学版)》2014年第1期。

[4] 1956年,正式提出“人工智能”概念,但是20世纪60年代末整个人工智能科学没有达到超越人类的预期而快速沉寂;到20世纪80年代末(1990年),囿于时代所具有的“知识获取瓶颈”,人工智能技术的研究由于再次没有达到人们的预期而进入了一个低谷期,几乎所有人工智能项目的科研经费被撤销。黄欣荣:《新一代人工智能研究的回顾与展望》,载《新疆师范大学学报(哲学社会科学版)》2019年第4期,第70-71页。王禄生:《司法大数据与人工智能技术应用的风险及伦理规制》,载《法商研究》2019年第2期,第102页。

[5] 20世纪90年代,但得益于“知识获取瓶颈”被突破,人工智能技术迎来第二次发展,从司法领域便可窥见一斑,如案件推理系统就已经可以从案件中提取事实,之后根据事实为双方当事人形成相应的辩论观点与反驳观点。周志华:《机器学习》,清华大学出版社2018年版,第1-2页;於兴中:《人工智能、话语理论与可辨驳推理》,载葛洪义主编:《法律方法与法律思维》(第3辑),中国政法大学出版社2005年版,第122-123页。

[6] 2016年3月,谷歌围棋人工智能AlphaGo以4:1击败韩国围棋选手李世石;2017年5月,AlphaGo以3:0击败中国围棋九段柯洁;2017年11月,美国国防部投资6500万美元用于“脑芯片”计划,开展人脑与机器对接,形成无障碍交流。倪楠:《人工智能发展过程中的法律规制问题研究》,载《人文杂志》2018年第4期,第123页。

[7] 2016年5月,欧盟委员会明确人工智能机器的法律身份并将其命名为“电子人”,使其享有有关知识产权和劳动权方面的权利;2016年10月,美国白宫科技政策办公室(OSTP)先后发布了《为人工智能的未来做好准备》和《国家人工智能研究与发展战略计划》两份研究报告;2016年10月,英国下议院的科学和技术委员会发布了一份关于人工智能和机器人技术的报告,该报告指出英国应不断巩固其在人工智能领域道德标准研究中的领先地位并不断加强对人工智能领域的监管研究。石月:《人工智能各国战略解读:欧盟机器人研发计划》,载《电信网技术》2017年第2期;尹昊智、刘铁志:《人工智能各国战略解读:美国人工智能报告解析》,载《电信网技术》2017年第2期;腾讯研究院:《人工智能各国战略解读:英国人工智能的未来监管措施与目标》,载《电信网技术》2017年第2期。

[8] [美]杰瑞·卡普兰:《人工智能时代》,李盼译,浙江人民出版社,2016年版。

[9] 管理学理论和管理实践显示,人具有趋利避害的本性,因此,无论对于企业职工,还是对于政府公务人员,都要既加以制约、又加以激励,才能提高效率。罗豪才、宋功德:《现代行政法学与制约、激励机制》,载《中国法学》2000年第3期。人工智能技术的出现,将有效地排除人类自身“趋利避改”等固有的人性弱点,进一步提高效率,促进发展。

[10] Drew Simshaw, Nicolas Terry, Kris Hauser, M. L. Cummings. Regulating Healthcare Robots: Maximizing Opportunities While Minimizing Risks. Richmond Journal of Law & Technology, No.22(Mar.,2016), pp.1-38.

[11] 张守文:《人工智能产业发展的经济法规制》,载《政治与法律》2019年第1期,第9页

[12] [美]库兹韦尔:《奇点临近——2045年,当代计算机智能超越人类》,李庆诚等译,机械工业出版社2017年版,第240页。

[13] 2015年7月,英国《金融时报》报道了德国大众公司的机器人“杀人事件”,一名工作人员被正在安装的机器人突然抓起重重摔向金属板而不治身亡。不过也有学者认为,在可预见的未来不会出现超过人类智能的人工智能,因而不必人为地制造恐慌。

[14] 2017年9月,浙江警方破获全国首例运用人工智能实施犯罪的案件。涉案平台利用人工智能技术快速识别验证码,截获、贩卖了10亿多组公民个人信息,供合作团伙进行网络诈骗。

[15] 斯坦福大学:《2030年的人工智能与生活》,人工智能百年研究,2016年10月发布。朱体正:《人工智能时代的法律因应》,载《大连理工大学学报(社会科学版)》2018年第2期,第99页。

[16] [美]I·R·诺巴克什:《机器人与未来》,刘金涛、李静译,西安交通大学出版社2015年版,第126页。

[17] 2015年5月,国务院颁布《中国制造2025》计划;2015年7月,国务院颁布《关于积极推进“互联网+”行动的指导意见》;2016年3月,国务院颁布《中华人民共和国国民经济发展第十三个五年规划纲要》;2016年4月,工信部、发改委和财政部联合发布《机器人产业发展规划(2016-2020年)》;2016年5月,发改委、科技部、工信部、网信办联合颁布《“互联网+”人工智能三年行动实施方案》;2016年7月,国务院颁布《“十三五”国家科技创新规划》;2016年9月,工信部、发改委联合发布《智能硬件产业创新发展专项行动(2016年-2018年)》计划;2016年11月,国务院颁布《“十三五”国家战略性新兴产业发展规划》;2017年3月,“人工智能”被首次写入政府工作报告;2017年7月,国务院发布《关于印发新一代人工智能发展规划的通知》;2017年10月,党的十九大报告中提出要推动人工智能深度发展;2017年12月,工信部发布《促进新一代人工智能产业发展三年行动计划(2018-2020年)》;2018年3月,政府工作报告中提出要加强新一代人工智能在不同领域的研发应用。

[18] 这里的不确定性,一方面是指人工智能本身的不确定性——模拟人类智力对不确定性的客观世界进行认知推理的机器、系统或网络具有不确定性;另一方面指人工智能发展与应用后果的不确定性。李德毅,杜鹃:《不确定性人工智能(第2版)》,国防工业出版社2014年版,第1-7页。朱体正:《人工智能时代的法律因应》,载《大连理工大学学报(社会科学版)》2018年第2期,第99页。

[19] [美]佩德罗·多明戈斯:《终极算法——机器学习的人工智能如何塑造世界》,黄芳萍译,人民邮电出版社2017年版,第364页。

[20] [英]詹姆斯·柯兰:《互联网的误读》,何道宽译,中国人民大学出版社2014年版,第340-341页。

[21] 倪楠:《人工智能发展过程中的法律规制问题研究》,载《人文杂志》2018年第4期,第128页。

[22] [美]波兹曼:《技术垄断———文明向技术投降》,蔡金栋等译,机械工业出版社2013年版,第74页。

[23] [美]约翰·帕克:《全民监控———大数据时代的安全与隐私困境》,关立深译,金城出版社2015年版,第299页。

[24] 2015年7月英国《金融时报》报道了德国大众公司的机器人“杀人事件”,一名工作人员被正在安装的机器人突然抓起重重摔向金属板而不治身亡。

[25] [美]约翰·马尔科夫:《人工智能简史》郭雪译,浙江人民出版社2017年版,第327页。

[26] 代码和算法是人工智能技术的主要实现方式,设计者们建立、测试和改进模型。然而,大多数智能系统都是不透明的,这意味着它们可以规避审查。同时,用户无从知晓自己的个人信息究竟流向何方,加之设计者们并不公开源代码,用户无法了解其中规则,便无法参与决策过程,只能被动接受结果,从而用户行为极易被控制。[美]卢格:《人工智能———复杂问题求解的结构和策略》,郭茂祖等译,机械工业出版社2017年版,第486页;[美]卢克·多梅尔:《算法时代:新经济的新引擎》胡小锐等译,中信出版社2016年版,第213页。汪庆华:《人工智能的法律规制路径:一个框架性讨论》,载《现代法学》2019年第2期,第60页。

[27] [美]弗兰克·帕斯奎尔:《黑箱社会——控制金钱和信息的数据法则》,赵亚男译,电子工业出版社2015年版,第259页。

[28] 数字鸿沟是指:在有效使用网络所需要的技能方面,比起仅仅去访问网络,会有着更深刻的阶层分化。[美]马修·辛德曼:《数字民主的迷思》,唐杰译,中国政法大学出版社2016年版,第11页。

[29] 这里的个人数据应广义理解,不仅包括能够直接识别公民个人身份的基本信息,还包括可以通过推断间接指明公民个人情况的其他相关信息。

[30] 王天一:《人工智能革命——历史、当下与未来》,北京时代华文书局2017年版,第184页。

[31] 个人信息权应具有占有、决定、保护、知情、更正、锁定和被遗忘等权能。杨立新:《民法总则要义与案例分析》,中国法制出版社2017年版,第413-418页。

[32] 马长山:《人工智能的社会风险及其法律规制》,载《法律科学》2018年第6期,第50页。

[33] 由于我国长期以来实行计划经济体制的原因,政府干预有其惯性,易言之,政府干预并非缘起于市场失灵,而是源于威权的认可,表现为政府计划性安排、调配市场资源、组织生产经营到产品分配一条龙服务的集中经营制度,干预之广,无远弗届。其基础理论便是“全能政府”。孙晋、钟瑛嫦:《我国政府投资决策制度的反思及补正》,载《学术论坛》2017年第1期,第123页。

[34] [美]弗兰克·帕斯奎尔:《黑箱社会——控制金钱和信息的数据法则》,赵亚男译,电子工业出版社2015年版,第259页。

[35] [美]佩德罗·多明戈斯:《终极算法——机器学习的人工智能如何塑造世界》,黄芳萍译,人民邮电出版社2017年版,第365页。

[36] 王利明:《人工智能对民法的挑战》,载《中国城市报》,2017年9月11日第7版。

[37] 我国传统的法律规制思路是“结果规制”,往往在消极后果出现之后进行被动规制,此为一种事后规制。而人工智能技术发展之后,其产生的不利后果往往是难以控制并且复杂多样的,采用传统的结果规制方式已经难以适应快速发展的人工智能技术,传统的立法技术存在一定欠缺,此时需引入新的立法技术——“过程规制”,即对代码和算法结果的规制转向对代码和算法产生的过程进行规制——通过把法律规则自身转化为代码,同时以代码来规制代码,这样一种“代码就是法律”的“技术法律化”立法理念可以在一定程度上避免因“结果规制”而产生的一些不可控因素。余盛峰:《全球信息化秩序下的法律革命》,载《环球法律评论》2013年第5期,第106-118页。[美]劳伦斯·莱斯格:《代码2.0:网络空间中法律》李旭等译,清华大学出版社2009年版,第6页。

[38] 马长山:《人工智能的社会风险及其法律规制》,载《法律科学》2018年第6期,第51页。

[39] 倪楠:《人工智能发展过程中的法律规制问题研究》,载《人文杂志》2018年第4期,第127页。

[40] 之所以实施过程监管的原因:是因为事后监管不仅意味着试错成本已经产生,同时还需要追加纠正成本,这些都将成为全社会的共同负担。向立力:《中国公平竞争审查制度的理论梳理、制度基础与机制完善》,载《法治研究》2017年第3期,第107页。

[41] 每个有权力的人都趋于滥用权力,而且还趋于把权力用至极致,这是一条万古不易的经验。The Spirit of the Laws, Bk, XI, ch. iii (the chapter numbers vary in different editions). 埃德加·博登海默:《法理学:法律哲学与法律方法》,邓正来译,北京,中国政法大学出版社,2017年版,第67页。

[42] 政府由于审批过多过滥而形成的政府“审批经济”,此时政府成为了借助行政权力谋求部门利益和单位利益的经济主体。张守文:《政府与法律关系的法律调整》,载《中国法学》2014年第5期,第66页。

[43] 丁茂中:《产业政策的竞争评估研究》,载《法学杂志》2016年第3期。

[44] 张守文:《公平竞争审查制度的经济法解析》,载《政治与法律》2017年第11期,第9页。

[45] 此时亟须解决人工智能主体性质的问题,是将“它”作为传统意义上归人类支配占有的物,还是赋予“他/她”独立法律人格并使其自负其责,不同的认定都将产生不同的责任认定标准。这一划分会对社会伦理造成重大冲击,笔者在此分类仅为一种学理假设,以便更好地进行责任划分。

[46] 日本拟修改《个人信息保护法》新增企业停发广告义务,载微信公众号“竞争法微网”,2019年4月27日。

[47] 虽然市场失灵产生了政府干预的需求,但是从各国的实践经验来看,盲目且不受法律制约的政府干预只会让市场失灵雪上加霜。孙晋、钟瑛嫦:《竞争政策的理论结构及其实施机制》,载《竞争政策研究》2015年第3期,第39页。

[48] 张守文:《市场主体负担轻重的法律调整》,载《法学评论》2019年第2期,第11页;马长山:《人工智能的社会风险及其法律规制》,载《法律科学》2018年第6期,第53页。

[49] “轻重理论”思想,以管仲为主要奠基人,其讲究政府干预市场(商业)要适宜,知轻重,减少政府权力对市场经济的过度干预。

[50] 徐恪、李沁:《算法统治世界——智能经济的隐形秩序》,清华大学出版社2017年版,第341页。

【参考文献】

{1} 列子.列子·汤问[M].景中,译注.北京:中华书局,2007:163-164.

{2} 中国电子技术标准研究院.人工智能标准化白皮书(2018版)[G].2018:5.

{3} [美]尼克.人工智能简史[M].北京:人民邮电出版社,2017:83-90.

{4} 吴汉东.人工智能时代的制度安排和法律规制[J].法律科学,2017,(5).

{5} 陈自富.前弗雷格时期的思维形式化[J].上海交通大学学报(哲学社会科学版),2014,(1).

{6} 张守文.人工智能产业发展的经济法规制[J].政治与法律,2019,(1).

{7} 黄欣荣.新一代人工智能研究的回顾与展望[J].新疆师范大学学报(哲学社会科学版),2019,(4).

{8} 王禄生.司法大数据与人工智能技术应用的风险及伦理规制[J].法商研究,2019,(2).

{9} 周志华.机器学习[M].北京:清华大学出版社,2018:1-2.

{10} 於兴中.人工智能、话语理论与可辨驳推理.葛洪义主编.法律方法与法律思维(第3辑)[M].北京:中国政法大学出版社,2005:122-123.

{11} 倪楠.人工智能发展过程中的法律规制问题研究[J].人文杂志,2018,(4).

{12} 石月.人工智能各国战略解读:欧盟机器人研发计划[J].电信网技术,2017,(2).

{13} 尹昊智,刘铁志.人工智能各国战略解读:美国人工智能报告解析[J].电信网技术,2017,(2).

{14} 腾讯研究院.人工智能各国战略解读:英国人工智能的未来监管措施与目标[J].电信网技术,2017,(2).

{15} [美]杰瑞·卡普兰.人工智能时代[M].李盼,译.杭州:浙江人民出版社,2016.

{16} 罗豪才,宋功德.现代行政法学与制约、激励机制[J].中国法学,2000,(3).

{17} Drew Simshaw, Nicolas Terry, Kris Hauser, M. L. Cummings. Regulating Healthcare Robots: Maximizing Opportunities While Minimizing Risks[J].Richmond Journal of Law & Technology,2016,22(3):1-38.

{18} [美]库兹韦尔.奇点临近--2045年,当代计算机智能超越人类[M].李庆诚,等译.北京:机械工业出版社,2017:240.

{19} 马长山.人工智能的社会风险及其法律规制[J].法律科学,2018,(6).

{20} 斯坦福大学.2030年的人工智能与生活[R].人工智能百年研究,2016,(10).

{21} 朱体正.人工智能时代的法律因应[J].大连理工大学学报(社会科学版),2018,(2).

{22} [美]I·R·诺巴克什.机器人与未来[M].刘金涛、李静,译.西安:西安交通大学出版社,2015:126.

{23} 张清,张蓉.“人工智能+法律”发展的两个面向[J].求是学刊,2018,(4).

{24} [英]张夏准.富国陷阱:发达国家为何踢开梯子?[M].肖炼,译.北京:社会科学出版社,2009:18.

{25} 江飞涛,李晓萍.直接干预市场与限制竞争:中国产业政策的取向与根本缺陷[J].中国工业经济,2010,(9).

{26} 张鹏飞,徐朝阳.干预抑或不干预?--围绕政府产业政策有效性的争论[J].经济社会体制比较,2007,(4).

{27} 吴敬琏.产业政策面临的问题:不是存废,而是转型[J].兰州大学学报(社会科学版),2017,(6).

{28} 吴军.智能时代:大数据与智能革命重新定义未来[M].北京:中信出版社,2016:340.

{30} 孙晋,钟瑛嫦.我国政府投资决策制度的反思及补正[J].学术论坛,2017,(1).

{31} [美]托斯.人工智能时代[M].赵俐,译.北京:人民邮电出版社,2017:69-79.

{32} [美]多梅尔.人工智能:改变世界,重建未来[M].赛迪研究院专家组,译.北京:中信出版社,2016:246.

{33} 王利明.人工智能对民法的挑战[N].中国城市报,2017-9-11(7).

{34} 金东寒.秩序的重构--人工智能与人类社会[M].上海:上海大学出版社,2017:156-158.

{35} [英]卡鲁姆·蔡斯.人工智能革命--超级智能时代的人类命运[M].张尧,译.北京:机械工业出版社,2017.

{36} [美]佩德罗·多明戈斯.终极算法--机器学习的人工智能如何塑造世界[M].黄芳萍,译.北京:人民邮电出版社,2017:364.

{37} [英]詹姆斯·柯兰.互联网的误读[M].何道宽,译.北京:中国人民大学出版社,2014:340-341.

{38} [美]波兹曼.技术垄断--文明向技术投降[M].蔡金栋,等译.北京:机械工业出版社,2013:74.

{39} [美] 约翰·帕克.全民监控--大数据时代的安全与隐私困境[M].关立深,译.北京:金城出版社2015:299.

{40} [美]约翰·马尔科夫.人工智能简史[M].郭雪,译.杭州:浙江人民出版社,2017:327.

{41} [美]卢格.人工智能--复杂问题求解的结构和策略[M].郭茂祖,等译.北京:机械工业出版社,2017:486.

{42} [美]卢克·多梅尔.算法时代:新经济的新引擎[M].胡小锐,等译.北京:中信出版社,2016:213.

{43} 汪庆华.人工智能的法律规制路径:一个框架性讨论[J].现代法学,2019,(2).

{44} [美]弗兰克·帕斯奎尔.黑箱社会--控制金钱和信息的数据法则[M].赵亚男,译.北京:电子工业出版社,2015:259.

{45} [美]马修·辛德曼.数字民主的迷思[M].唐杰,译.北京:中国政法大学出版社,2016:11.

{46} 王天一.人工智能革命--历史、当下与未来[M].北京:北京时代华文书局,2017:184.

{47} 杨立新.民法总则要义与案例分析[M].北京:中国法制出版社,2017:413-418.

{48} [美]弗兰克·帕斯奎尔.黑箱社会--控制金钱和信息的数据法则[M].赵亚男,译.北京:电子工业出版社,2015:259.

{49} [美]佩德罗·多明戈斯.终极算法--机器学习的人工智能如何塑造世界[M].黄芳萍,译.北京:人民邮电出版社,2017:365.

{50} 余盛峰.全球信息化秩序下的法律革命[J].环球法律评论,2013,(5).

{51} [美]劳伦斯·莱斯格.代码2.0:网络空间中法律[M].李旭,等译.北京:清华大学出版社,2009:6.

{53} 孙晋,钟瑛嫦.竞争政策的理论结构及其实施机制[J].竞争政策研究,2015,(3).

{54} 张守文.政府与法律关系的法律调整[J].中国法学,2014,(5).

{55} 向立力.中国公平竞争审查制度的理论梳理、制度基础与机制完善[J].法治研究,2017,(3).

{56} The Spirit of the Laws[M]. Bk, XI, ch. iii (the chapter numbers vary in different editions).

{57} [美]埃德加·博登海默.法理学:法律哲学与法律方法[M].邓正来,译.北京:中国政法大学出版社,2017:67.

{58} 丁茂中.产业政策的竞争评估研究[J].法学杂志,2016,(3).

{59} 张守文.公平竞争审查制度的经济法解析[J].政治与法律,2017,(11).

{60} 张守文.市场主体负担轻重的法律调整[J].法学评论,2019,(2).

{61} 徐恪,李沁.算法统治世界--智能经济的隐形秩序[M].北京:清华大学出版社,2017:341.